| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- 그래픽스

- 컴퓨터 비전

- recommender system

- 딥러닝

- CNN

- 파이썬

- Kaggle

- 컴퓨터 그래픽스

- Computer Vision

- Vision

- 비용함수

- 로지스틱 회귀

- 추천 시스템

- SVM

- OpenGL

- 신경망

- 인공지능

- neural network

- Regularization

- SGD

- 백준

- pre-trained

- Support Vector Machine

- cs231n

- petal to metal

- C++

- CPP

- Unsupervised learning

- 머신러닝

- logistic regression

- Today

- Total

kwan's note

neural network - 신경망 모델 본문

출처: machine learning by andrew ng, stanford cousera lecture

수강일시: 2021.01.28

reminder-by-kwan.tistory.com/95

neural network -신경망 구조의 필요성

출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.01.28 reminder-by-kwan.tistory.com/85?category=962582 machine learning - Andrew Ng, Stanford(coursera) 이 복습노트는 Stan..

reminder-by-kwan.tistory.com

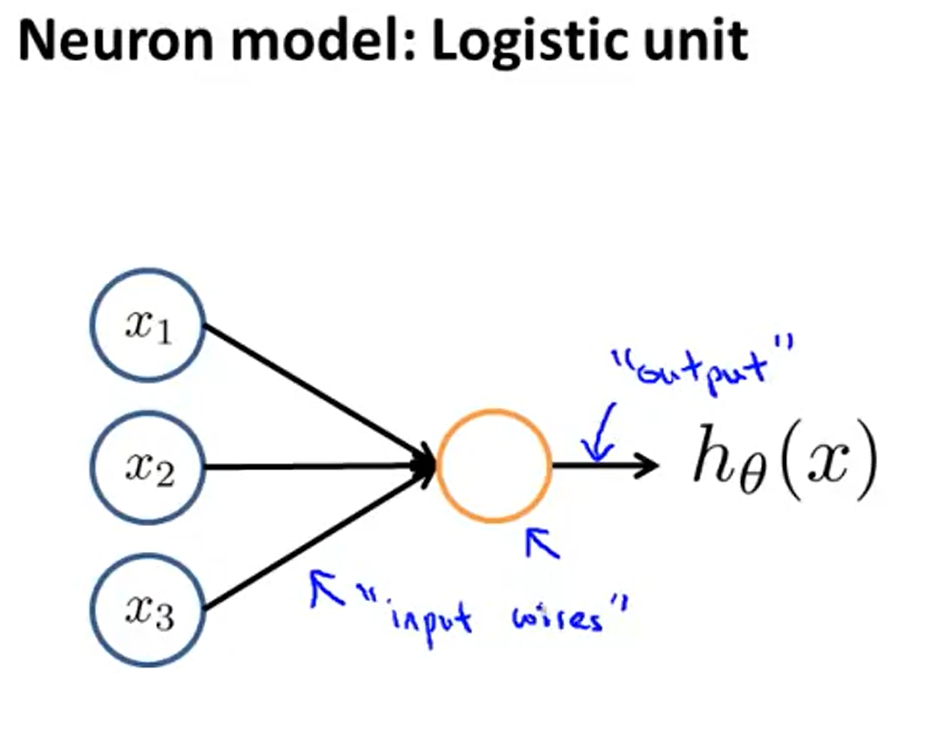

이전수업에 이어 neural network의 이론과 모델을 표현하는 방법에대해 배워보도록 하겠습니다.

neuron은 dendrite라는 input을통해 들여온값을 연산하여 Axon을 통해 output을 준다.

수만은 뉴론들이 연결되어 이러한 작업을 반복하게된다.

따라서 아래와같은 모델을 만들었다.

input feature를 가지고 어떠한 연산을 진행하고 이를통해 결과값을 얻게된다. 이를통해 가설함수 h를 얻는다.

추가적으로 상수값 bias를 주기도 한다(오차를 줄이기 위해)

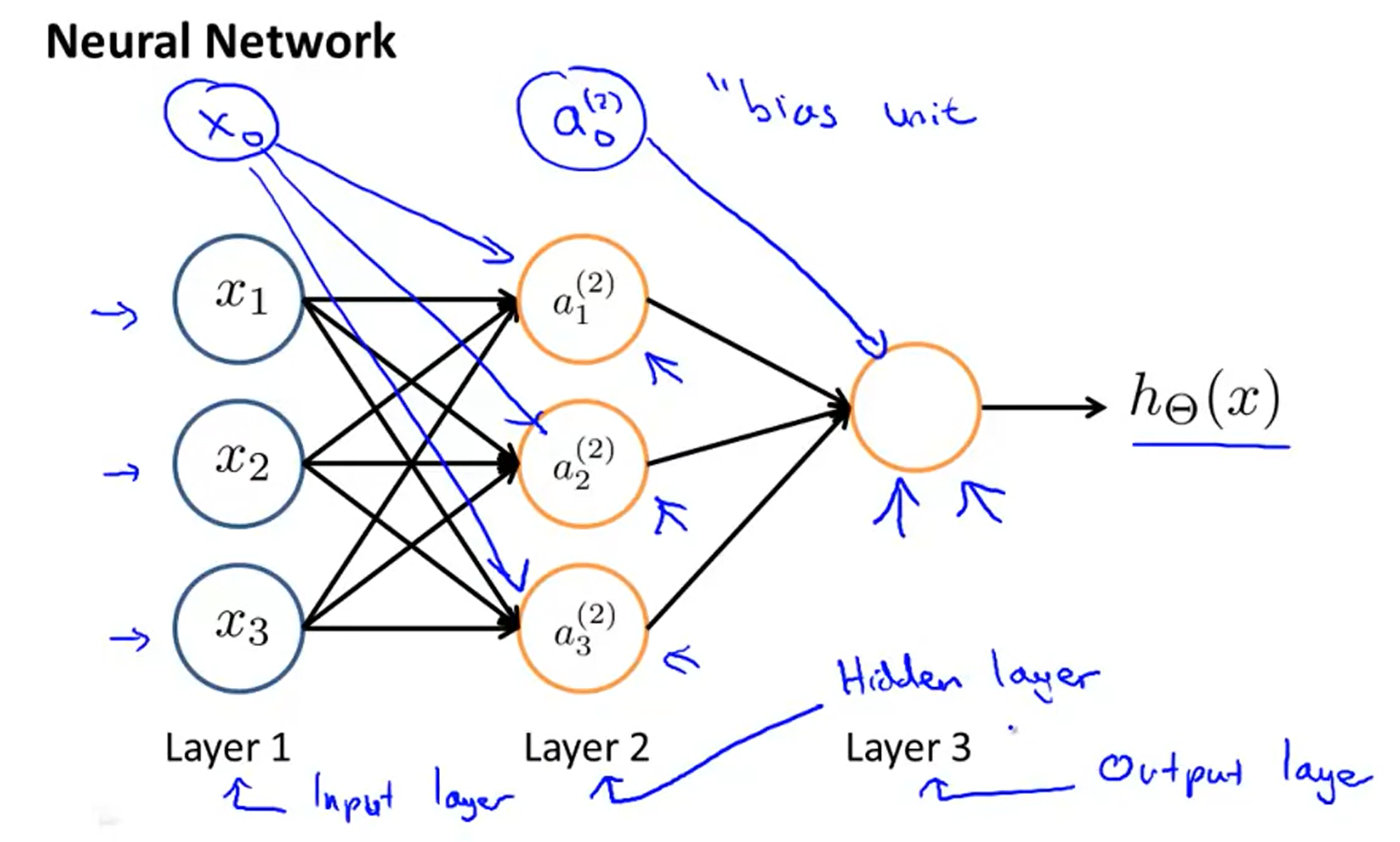

이러한 연산의 반복을 통해 최초 input으로부터 새로운 특성을 얻고 그로부터 가설함수가 얻어지도록 한다.

첫번째 feature를 input layer라고 하고 중간을 hidden layer라고 한다.

이를 간단하게 식으로 표현하면 다음과 같다.

즉 하나의 결과가 다음 연산의 기초가 된다.

만약 network가 layer j에 Sj개의 unit을 가지고 layer j+1에는 S(j+1)개의 유닛을 가진다면 theta j는 S(j+1)X(Sj +1)의 차원이 될 것이다.

Example: If layer 1 has 2 input nodes and layer 2 has 4 activation nodes. Dimension of \Theta^{(1)} is going to be 4×3 where s_j = 2 and s_{j+1} = 4, so s_{j+1} \times (s_j + 1) = 4 \times 3.

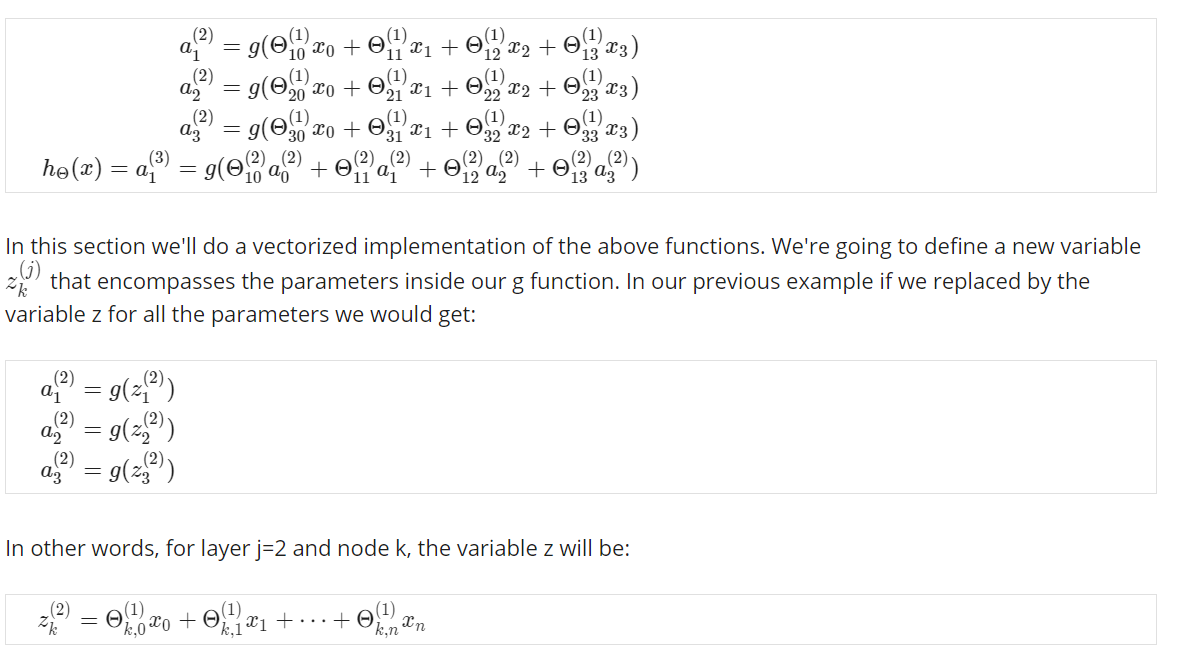

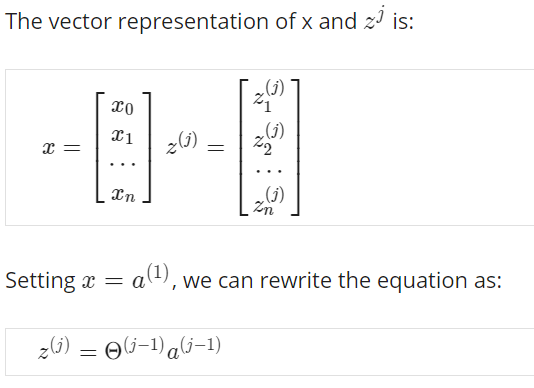

이번에는 vectorize하여 표현해보도록 하겠다.

z를 다음과 같이 theta 와 x의 결합으로 표현하였다.

위와 같은 벡터 z에 대해 원래함수를 표현하면 다음과 같이 표현할 수 있다.

이는 다시 다음과 같이 표현할 수 있고

z(j+1)=Θ(j)a(j)

결과적으로 우리는 다음과 같은 가설함수 h를 얻을 수 있다.

hΘ(x)=a(j+1)=g(z(j+1))

사실 우리는 마지막 layer에서 로지스틱회귀에서 진행한것과 매우 유사한 일을 하고 있다. 하지만 이러한 중간 layer 연산을 추가하고 계속 진행하면서 더 정확하고 확실한 결과를 얻을 수 있다.

이러한 복잡한 계산이 어떻게 더 나은 결과를 제공하는지는 다음 수업에서 알아보도록 하겠습니다.

reminder-by-kwan.tistory.com/97

neural network - 신경망 모델 이용 방법

출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.01.28 reminder-by-kwan.tistory.com/96 neural network - 신경망 모델 출처: machine learning by andrew ng, stanford cousera..

reminder-by-kwan.tistory.com

'ML and AI > Machine learning - Andrew Ng' 카테고리의 다른 글

| back propagation in neural network - 역전파 (0) | 2021.01.29 |

|---|---|

| neural network - 신경망 모델 이용 방법 (0) | 2021.01.28 |

| neural network -신경망 구조의 필요성 (0) | 2021.01.28 |

| regularization - 정규화 (0) | 2021.01.27 |

| overfitting- 과적합 (0) | 2021.01.26 |