| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- 그래픽스

- Computer Vision

- CPP

- 파이썬

- recommender system

- SVM

- 신경망

- Support Vector Machine

- neural network

- 추천 시스템

- CNN

- 컴퓨터 그래픽스

- 머신러닝

- Kaggle

- 백준

- 로지스틱 회귀

- 인공지능

- petal to metal

- 컴퓨터 비전

- SGD

- 비용함수

- C++

- Unsupervised learning

- 딥러닝

- Vision

- pre-trained

- cs231n

- logistic regression

- OpenGL

- Regularization

- Today

- Total

kwan's note

back propagation in neural network - 역전파 본문

back propagation in neural network - 역전파

kwan's note 2021. 1. 29. 02:50출처: machine learning by andrew ng, stanford cousera lecture

수강일시: 2021.01.29

reminder-by-kwan.tistory.com/97

neural network - 신경망 모델 이용 방법

출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.01.28 reminder-by-kwan.tistory.com/96 neural network - 신경망 모델 출처: machine learning by andrew ng, stanford cousera..

reminder-by-kwan.tistory.com

neural network에서 역전파에 대해 알아보겠습니다.

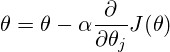

역전파 알고리즘은 cost function을 최소화 하는 값 J(theta)를 구함에 있어서 J의 theta에 대한 미분값을 얻는 하나의 방법입니다.

역전파는 아래와 같은 방법으로 진행됩니다.

먼저 train set에 대해 froward propagation 즉 전파를 진행하여 오른쪽 layer의 activation을 구합니다.

이를 이용하여 delta(L) 즉 오차를 구합니다. 이 오차를 이용하여 L-1 layer의 activation에 해당하는 오차를 구하고 그로부터 앞의 오차를 구하는방식으로 진행해 나갑니다. 마지막으로 이를 이용해 J의 편미분 값을 구합니다.

이를 줄글과 sudo code로 표현하면 아래와 같습니다.

위의 식이 복잡하므로 이를 도식화하여 표현하면 아래와 같습니다.

먼저 foward propagation 즉 정방향 전파입니다.

input x에 대해 앞으로 연산을하며 채워나갑니다. 최종적으로 L번째 layer의 activation이 채워지면 오차 delta를 구합니다.

다음으로 역전파가 진행됩니다.

'ML and AI > Machine learning - Andrew Ng' 카테고리의 다른 글

| SVM support vector machine - 서포트 벡터 머신 (0) | 2021.02.04 |

|---|---|

| cross validation and fitting - 교차 검증과 피팅 (0) | 2021.01.31 |

| neural network - 신경망 모델 이용 방법 (0) | 2021.01.28 |

| neural network - 신경망 모델 (0) | 2021.01.28 |

| neural network -신경망 구조의 필요성 (0) | 2021.01.28 |