| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- Regularization

- CPP

- 파이썬

- 컴퓨터 그래픽스

- 비용함수

- CNN

- Support Vector Machine

- 그래픽스

- petal to metal

- neural network

- Kaggle

- recommender system

- OpenGL

- 백준

- 딥러닝

- SGD

- 머신러닝

- cs231n

- 로지스틱 회귀

- 컴퓨터 비전

- SVM

- Vision

- 인공지능

- Unsupervised learning

- 신경망

- 추천 시스템

- pre-trained

- Computer Vision

- logistic regression

- C++

- Today

- Total

kwan's note

최소제곱 문제(Least Squares Problem) 본문

출처: 부스트코스-인공지능을 위한 선형대수

수강일시:2021.01.06

이번 내용은 초반에 고등학교 과정과 겹치는것이 많아 일부는 설명을 하지 않고 슬라이드로 대체하였습니다.

내적의 성질

vector 의 norm

벡터의 norm은 길이를 나타낸다. 벡터의 norm은 자기 자신과의 내적이다.

벡터의 상수배의 norm은 norm의 상수배와 같다.

벡터의 u,v의 거리는 ll v-u ll

즉 차이벡터의 norm이다.

내적과 각도의 관계

overdetermind system

variable보다 equation의 숫자가 더 많을때 해가 존재하지 않는다.

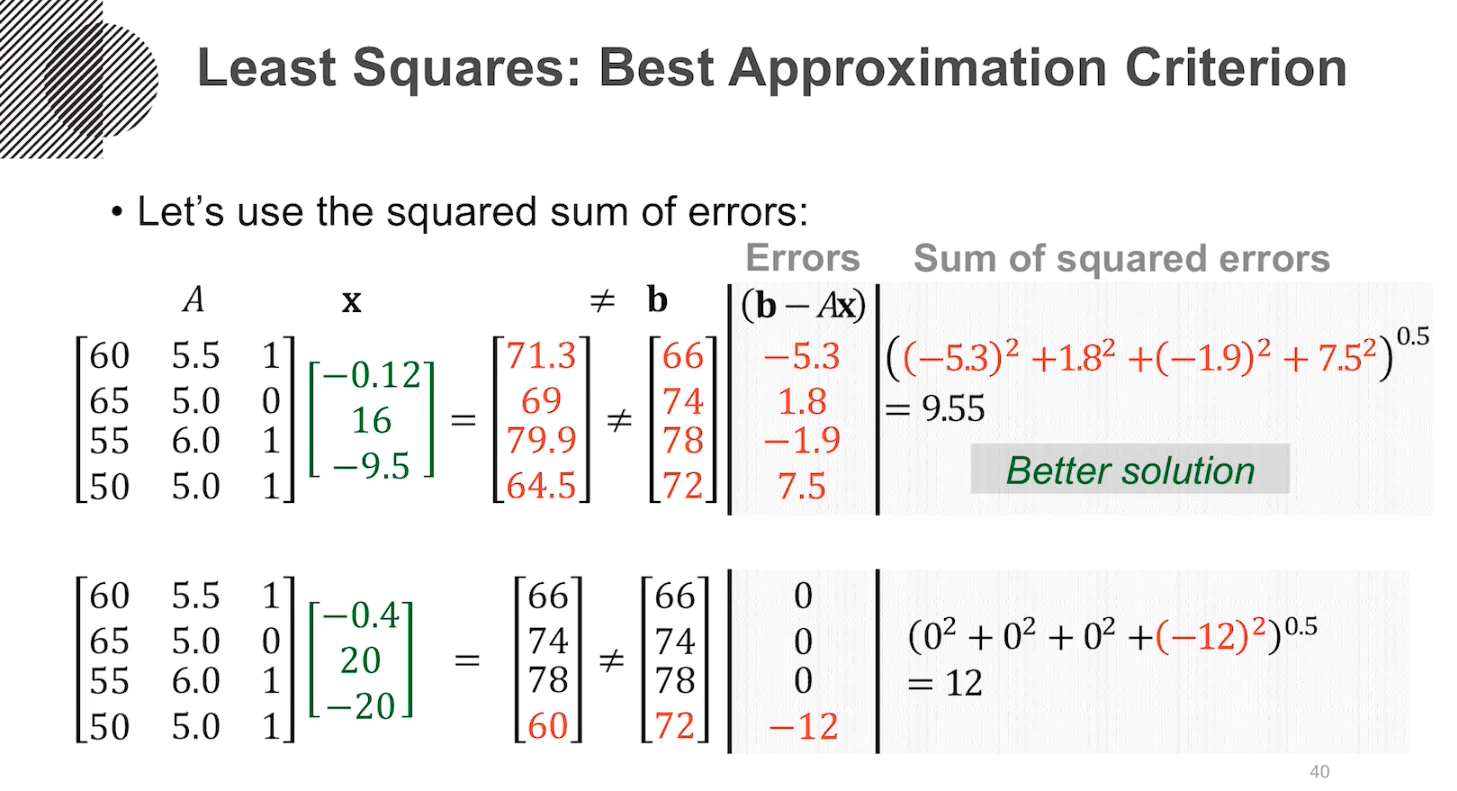

이런경우 근사적으로 해를 구하기 위한 방법으로 제곱을 최소화 하는 방법으로 해결하는 가장 기초적인 근사방법이다.

error의 총점을 계산하는 방법으로 제곱의 합을 더하는 방식이다.

overdetermind system에서 오차가 발생하게 될 때 하나의 outlier로 오차가 매우 크게 발생하는것보다

에러 각각의 제곱합이 최소가 되도록 하는 방식을 만들고자한다.

ll b-Ax ll를 최소로하는 값을 xhat이라고 하면 이때 b는 bhat이 된다.

이는 모든 x hat이 아닌 x에대해 ll bhat -Axhat ll 은 ll b-Ax ll보다 작다

b-bhat은 colA 평면내 모든 벡터와 수직이다.

즉 임의의 Ax와 b-bhat은 수직이 된다.

(b-bhat) dot (a1x1+a2x2+a3x3) = 0

이를 다시 쓴다면

AT(b-Axhat)=0

ATb=ATAxhat=0

이어서 다음에 정규방정식에 대한 강의내용을 작성하겠습니다

'Math > Linear algebra' 카테고리의 다른 글

| 정사영 (Orthogonal Projection) (0) | 2021.01.07 |

|---|---|

| 정규방정식 (0) | 2021.01.06 |

| 전사함수(Onto, Surjective)와 일대일함수(One-to-one, Injective) (0) | 2021.01.06 |

| 선형변환(Linear Transformation) (0) | 2021.01.06 |

| 부분공간의 기저와 차원 (0) | 2021.01.06 |