| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

| 29 | 30 |

- Vision

- neural network

- 비용함수

- SVM

- SGD

- cs231n

- C++

- 로지스틱 회귀

- Regularization

- 추천 시스템

- 컴퓨터 비전

- Support Vector Machine

- 그래픽스

- 딥러닝

- pre-trained

- OpenGL

- 인공지능

- CNN

- 컴퓨터 그래픽스

- 파이썬

- recommender system

- 신경망

- 머신러닝

- logistic regression

- Unsupervised learning

- Computer Vision

- Kaggle

- CPP

- 백준

- petal to metal

- Today

- Total

kwan's note

선형변환(Linear Transformation) 본문

출처: 부스트코스-인공지능을 위한 선형대수

수강일시:2021.01.05

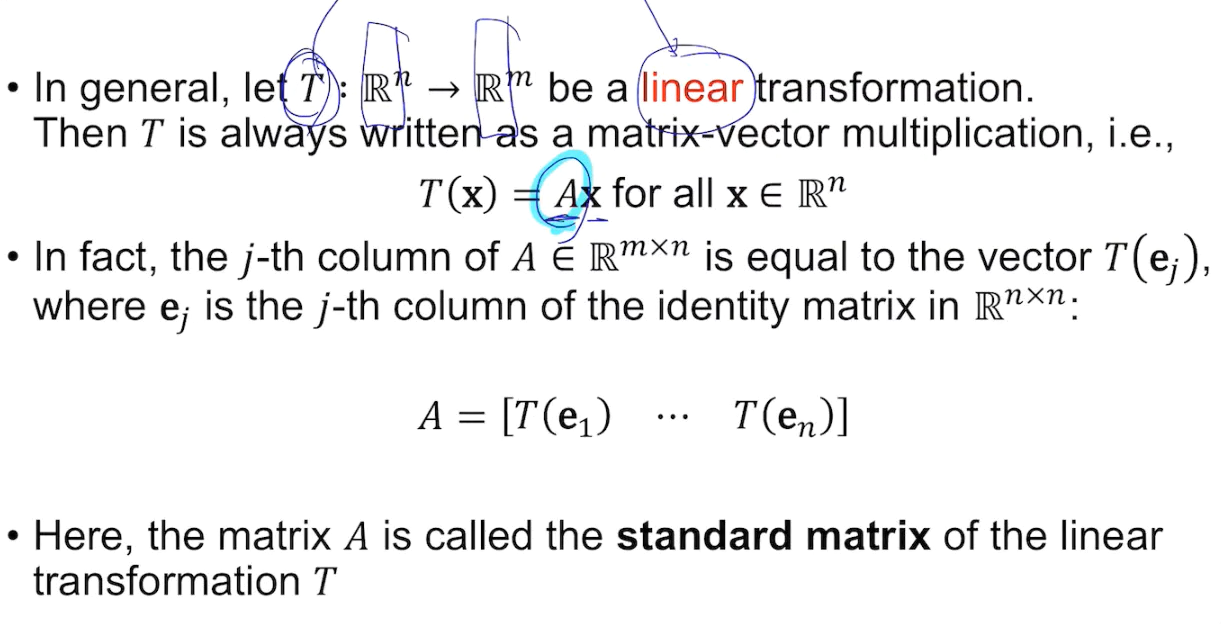

주어진 정의역에서 두개의 벡터를 뽑아서 선형결합하여 나온 결과값이 선형결합에서의 계수를 각각 취했을때 나온 결과값과 동일할때 lenear transform(선형 변환)이라고 한다. 즉, 위 사진에서처럼 두가지 계산의 결과가 같아야한다.

y=3x+2를 보자.

x=1을대입하면 5

x=2대입하면 8

3x1+4x2=11

3x11+2 =35

3x5+4x8= 47

그럼에도 불구하고 bias가 들어갔을때에도 이를 선형 변환이라고 한다. 그 이유는

[3 2] [x 1]t = 3x + 2

이렇게 표현한다면 R^2 -> R로가는 식으로 변형하면 bias가 없어져 선형변환이 된다.

[x1 x2]T 는 standard basis의 상수곱 x1[1 0]T + x2[0 1]T으로 나타낼 수 있다

T가 선형결합을 만족하므로 분해하고 이를 linear combination으로 행렬로 구성하면 T를 파악할 수 있다.

따라서,

선형성을 만족하는 변환은 행렬과 입력벡터의 곱으로 나타나는 행렬이된다.

이를 일반화시키면

기저벡터들을 넣어서 A를 알 수 있다.

결국 선형변환은 fully connected layer의 가장 기본적인 형태가 된다.

기하학적으로 본다면 직교좌표계를 평행사변형의 좌표계로 변환시키는 꼴이 된다.

neural net에서 4개의 input layer에서 3개의 output layer라고 한다면

bias를 추가하는 경우가 대부분인데 이때 linear transformation이 아닌 affine transformation이 되는데 위에서 사용한것과 동일한 trick을 사용하여 선형변환으로 만들어 사용할 수 있다.

'Math > Linear algebra' 카테고리의 다른 글

| 최소제곱 문제(Least Squares Problem) (0) | 2021.01.06 |

|---|---|

| 전사함수(Onto, Surjective)와 일대일함수(One-to-one, Injective) (0) | 2021.01.06 |

| 부분공간의 기저와 차원 (0) | 2021.01.06 |

| 선형독립과 선형종속(Linear Independence and Linear Dependence) (0) | 2021.01.05 |

| 선형결합(Linear Combination), 스팬(span) (0) | 2021.01.05 |