| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | |||

| 5 | 6 | 7 | 8 | 9 | 10 | 11 |

| 12 | 13 | 14 | 15 | 16 | 17 | 18 |

| 19 | 20 | 21 | 22 | 23 | 24 | 25 |

| 26 | 27 | 28 | 29 | 30 | 31 |

- 파이썬

- 백준

- OpenGL

- CNN

- 인공지능

- pre-trained

- 로지스틱 회귀

- 추천 시스템

- 머신러닝

- 신경망

- Support Vector Machine

- logistic regression

- Computer Vision

- Regularization

- cs231n

- Kaggle

- 컴퓨터 비전

- Vision

- CPP

- C++

- recommender system

- neural network

- petal to metal

- SGD

- 비용함수

- Unsupervised learning

- 컴퓨터 그래픽스

- 딥러닝

- 그래픽스

- SVM

- Today

- Total

목록분류 전체보기 (159)

kwan's note

Backpropagation -역전파

Backpropagation -역전파

출처: cs231n 이전 lecture reminder-by-kwan.tistory.com/116 linear classification with softmax - 소프트맥스 회귀 출처 : cs231n lecture3 www.youtube.com/watch?v=h7iBpEHGVNc 이번에는 저번시간에 이어서 linear classification의 방식에 대해 알아보도록 하겠습니다. reminder-by-kwan.tistory.com/115 linear classificatio.. reminder-by-kwan.tistory.com 지금까지 loss function을 구하고 gradient descent 방식을 통해 optimize를 진행했습니다. 이제는 neural network에서 중요한 개념중 하나..

linear classification with softmax - 소프트맥스 회귀

linear classification with softmax - 소프트맥스 회귀

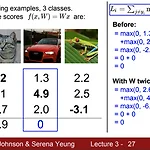

출처 : cs231n lecture3 www.youtube.com/watch?v=h7iBpEHGVNc 이번에는 저번시간에 이어서 linear classification의 방식에 대해 알아보도록 하겠습니다. reminder-by-kwan.tistory.com/115 linear classification, SVM - 선형 분류 출처 : cs231n lecture2 www.youtube.com/watch?v=OoUX-nOEjG0&list=PLC1qU-LWwrF64f4QKQT-Vg5Wr4qEE1Zxk&index=2 linear classification은 매우 기본이 되는 분류 방식이다. neural network의 근간이 되는 분류.. reminder-by-kwan.tistory.com 저번시간에 사용하였던..

linear classification, SVM - 선형 분류

linear classification, SVM - 선형 분류

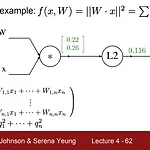

출처 : cs231n lecture2 www.youtube.com/watch?v=OoUX-nOEjG0&list=PLC1qU-LWwrF64f4QKQT-Vg5Wr4qEE1Zxk&index=2 linear classification은 매우 기본이 되는 분류 방식이다. neural network의 근간이 되는 분류 방식이기도 하다. linear classification은 특징들이 parameter 형식으로 요약되어서 그 내적의 결과가 결과로 나타나는 방식이다. parametric approach를 보도록 하자. input으로 이미지를 넣으면 어떠한 계산을 진행하고 그 걸과로 값들을 반환받는다. 이때 반환값은 각 클래스의 점수가 되는데 해당점수가 가장 높은 클래스를 이미지의 클래스로 선택하게 된다. 이미지를 2..

k nearest neighbor - k 최근접 이웃

k nearest neighbor - k 최근접 이웃

출처: cs231n lecture 2 www.youtube.com/watch?v=OoUX-nOEjG0&list=PLC1qU-LWwrF64f4QKQT-Vg5Wr4qEE1Zxk&index=2 이미지의 classification 문제중 가장 먼저 떠올릴수 있는 방법중 하나인 최근접이웃 알고리즘이다. 최근접 이웃 알고리즘은 말 그대로 가장 가까운 데이터의 결과값을 그대로 출력한다는것이다. 위와 같이 k=1 인경우 특정 데이터에 대해 점은 train set의 data고 색은 그 결과값(y)라고 할때 영역의 표시이다. 특정점에 대해 가장 가까운 점의 위치를 파악해 그 데이터의 결과값을 가져온다. 하지만 위처럼 섬이 생기게 되고 이는 옳지 못할 가능성이 매우 크다. 특이점에 매우 민감하게 반응하며 위와같은 실수를 범..

이 노트는 Fei-Fei li 교수님의 spring 2017 cs231 lecture를 기반으로 작성하였습니다. 작년말 이 강의를 추천받고 초반 3개정도의 강의를들었는데 당시에 머신러닝에 최소한의 개념도 부족해서 어느 순간부터 이해하지 못하고 포기했다. 이번 방학기간동안 몇개의 강의를 더 들었고 이제 다시 공부하고자 한다. CS231n: Convolutional Neural Networks for Visual Recognition www.youtube.com/watch?v=vT1JzLTH4G4&list=PLC1qU-LWwrF64f4QKQT-Vg5Wr4qEE1Zxk 이는 2017년 강의로 2020년강의 혹은 그 이후의 강의 슬라이드와 약간 변화가 있지만 전체 강의가 공개된 2017년강의를 기준으로 작성하였..

머신러닝 성능을 높이는 방법

머신러닝 성능을 높이는 방법

출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.02.08 마지막으로 머신러닝 성능을 높이기 위한 방법을 생각해 보도록 하겠습니다. 데이터의 숫자가 정해진 경우의 처리 방법에대해서는 (bias 와 variance를 조절하는 방법, 파라미터 람다를 조절하여 regularization하는 방법, 데이터가 많은경우 SGD, mini batch 혹은 online learning 등) 이미 전 수업에서 다루었습니다. 그렇다면 이제 데이터의 숫자를 어떻게 늘릴수 있는지 먼저 생각해 보도록 하겠습니다. 가지고 있는 데이터셋을 글자의 이미지라고 해 봅시다. 이때 가지고 있는 데이터를 변형한다면 또 다른 데이터셋을 만들 수 있게됩니다. 가령 ..

online learning , map reducing -온라인 학습, 병렬 학습

online learning , map reducing -온라인 학습, 병렬 학습

출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.02.07 reminder-by-kwan.tistory.com/110 Mini batch gradient descent 출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.02.07 reminder-by-kwan.tistory.com/109 Stochastic gradient descent(SGD) -확률적 경사 하강법 출처: machine learning by and.. reminder-by-kwan.tistory.com 이번에도 데이터가 많은경우 처리방법에 대해 배워보도록 하겠습니다. 첫번째 주제는 o..

Mini batch gradient descent

Mini batch gradient descent

출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.02.07 reminder-by-kwan.tistory.com/109 Stochastic gradient descent(SGD) -확률적 경사 하강법 출처: machine learning by andrew ng, stanford cousera lecture 수강일시: 2021.02.06 reminder-by-kwan.tistory.com/89?category=962582 gradient descent(경사하강법) 출처: machine learning by andrew ng, s.. reminder-by-kwan.tistory.com 이번시간에도 저번시간에 이어 데이터가 매우 많은..